蘋果要偷看你手機電腦上的照片了

歡迎關注“新浪科技”的微信訂閱號:techsina

文/杜晨 編輯/Lianzi

來源/硅星人(ID:guixingren123)

大家可能記得,蘋果最近幾年一直在用的,宣傳 iOS 系統隱私性的廣告語:

“What happens on your iPhone, stays on your iPhone.”

Or does it? 事實真的如此嗎?

過去的事情暫且不提。我們現在可以肯定的是,在今年晚些時候發布的 iOS 15 和最新版 Mac 操作系統Monterey上,蘋果就要堂而皇之地“偷看”你的照片了。

發生了什么

昨天,約翰·霍普金斯大學加密學教授 Matthew Green 在 Twitter 上突然爆出一條大新聞:多名知情人士確認,蘋果即將發布一項用于掃描檢測兒童色情虐待內容 (Child Sexual Abuse Material) 的端側工具。

端側的意思就是掃描工作在用戶設備上完成。截圖來源:Matthew Green 的 Twitter 賬號

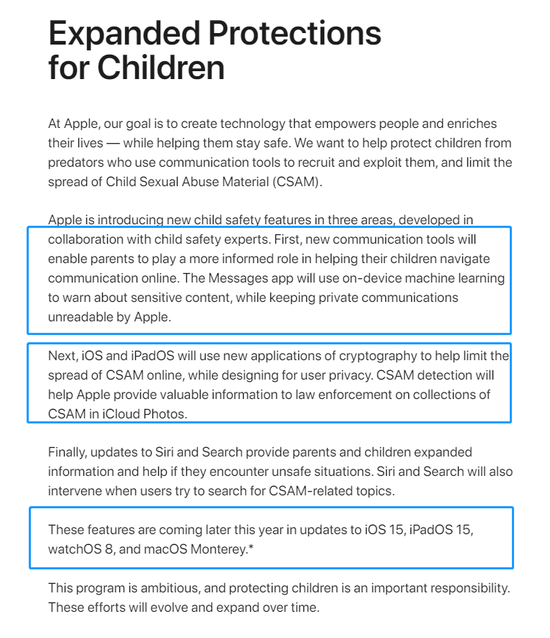

端側的意思就是掃描工作在用戶設備上完成。截圖來源:Matthew Green 的 Twitter 賬號今天,蘋果也在官網正式宣布了這一消息:

截圖來源:蘋果官網 https://www.apple.com/child-safety/

截圖來源:蘋果官網 https://www.apple.com/child-safety/這個系統的工作原理大概是這樣的:

首先,蘋果會對用戶在 iPhone 等各類蘋果設備上接收、保存和發送的照片提取哈希值。

然后,蘋果會用這個值和美國“國家失蹤和被剝削兒童中心”的數據庫進行比對,驗證涉事照片是否屬于兒童色情虐待內容。這個數據庫將會保存在用戶設備的本地。比對檢測工作也是在本地完成的。

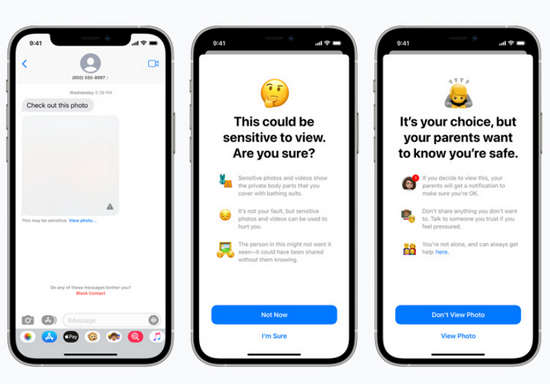

用戶在 iMessage 上收到或者發送照片。系統會在后臺完成比對檢測工作。如果系統認為它屬于露骨內容,iMessage 就會暫時屏蔽掉這張照片、詢問,并再次確認用戶是否要瀏覽或發送這張照片。

不僅如此,如果用戶本身是少年兒童,并且設置了家庭賬號的話,iOS 系統還會通知家長。

圖片來源:蘋果

圖片來源:蘋果如果你以為所有這些真的全部在本地完成的,不涉及到蘋果公司層面的隱私嗅探行為,那你就太小看蘋果了。蘋果也會用類似的哈希算法對用戶發送到 iCloud 保存的照片(同樣端到端加密)進行檢測,并且在上傳之前給照片文件增加一串保密信息。

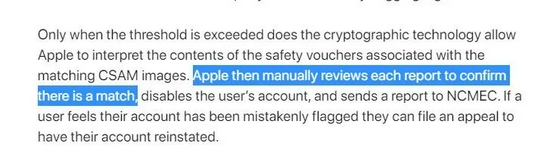

如果涉事照片被判定為兒童色情虐待內容,蘋果的服務器將可以對照片進行解密,并且交由人工進行二次審核。

安全專家認為,蘋果設計的這套打擊兒童色情的技術,雖然設計目的是好的,但可能存在嚴重的安全和隱私風險,并且完全顛覆了“端到端加密”原本存在的意義。

事件的影響

“最初我的理解是,這項技術用于在端側對云存儲的照片進行掃描。但是最終,它可能會成為在加密通訊系統中增加監控的一個關鍵因素。”Green 評論道。他還表示,在端到端通訊系統中加入這樣的掃描系統,一直以來都是全球各地執法部門的主要需求。

“棱鏡”計劃的爆料人愛德華·斯諾登也對蘋果此舉頗為不滿,甚至在 Twitter 上發布了一張梗圖吐槽:

左邊:蘋果2015年:我們不讓 FBI 查看死掉的恐怖分子的手機,只為保護你的隱私。

右邊:蘋果2021年:我們會用官方黑名單檢測你的相片冊和 iCloud 照片,除了報警之外,還會告訴你家長……

不管怎樣,蘋果將會在新版操作系統里“偷看”你的照片這件事,算是坐實了。

至于什么"What happens on your iPhone stays on your iPhone",只是少數用戶一廂情愿的假象了……

需要明確的是,蘋果并不是第一家、唯一一家在做類似事情的公司。包括谷歌(從2008年開始)、微軟(2009年)、Facebook(2011年)和 Twitter(2013年)等公司,都已經在用哈希算法等相關技術,對兒童色情虐待內容進行預防、偵測和打擊了。

知名互聯網用戶權益機構“電子前線基金會”(EFF) 在2019年曾經撰文指出:這種號稱專為打擊兒童色情內容而設計的所謂“用戶端側掃描工具”,是一個偽命題。

1)從技術上來講,這類工具無法將其檢測能力限制在兒童色情這一類內容上。

具體來說,這類檢測技術核心原理都是對圖片提取哈希值,然后和一個“官方”的數據庫進行比對。

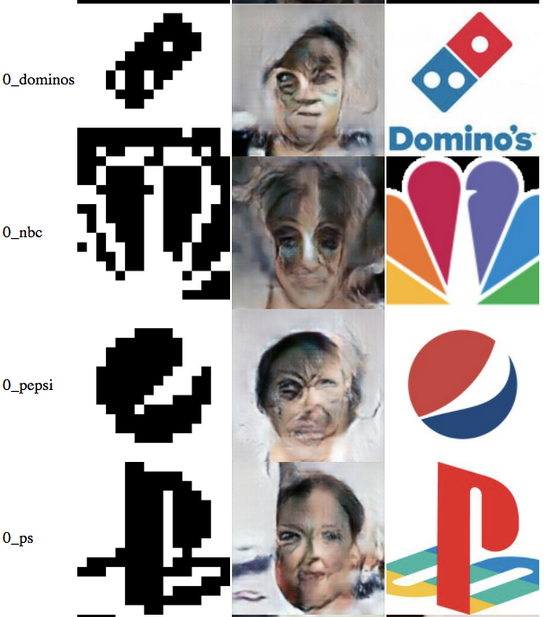

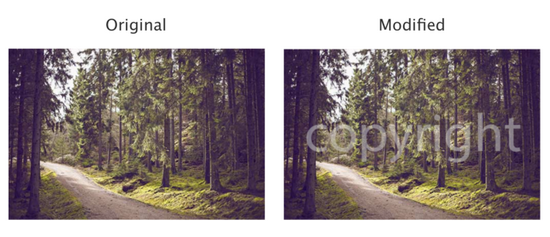

但是目前機器學習領域已經有了先進的生成對抗網絡技術,可以對兩個不同的文件,比如兩張完全不同的照片,實現“哈希碰撞”(也即這兩張完全不同的照片擁有相同的哈希值):

圖示:右邊一列的公司 logo 和中間一列用算法生成的“人臉”圖片,實現了哈希碰撞。圖片來源:Nick Locascio

任何擁有官方數據庫操作權限的人,都可以自己添加新的哈希值條目到數據庫,從而擴大這個圖片檢測系統,所檢測和審查的對象范圍。

EFF 指出,在這樣的場景下,“由于數據庫只包含哈希值,而兒童色情圖片的哈希值和其它圖片的哈希值(可能)沒有區別,那么掃描兒童色情內容的系統,就無法從技術上只針對兒童色情內容。”

2)EFF 還指出,這類所謂的端側掃描工具,實際上打破了端到端加密的承諾。

端到端加密的普遍定義是:在一個通訊系統中,只有內容的發送端和接收端可以看到所發送的內容,其他任何人,包括其他用戶,以及通訊系統的運營者(蘋果)都無法看到,也沒有能力對通過加密方式傳送的信息進行解密。

“如果一個系統有直接、有效解密很大一部分信息的能力,它就不再是一個端到端加密的系統了,”EFF 指出。

3)前面提到,蘋果的這個檢測系統,一旦偵測到可能的兒童色情內容,還會引入真人進行二次檢驗。這就進一步擴大了用戶隱私泄露的風險。

目前蘋果沒有透露究竟誰有權限查看這些照片,是蘋果自己的員工還是外包機構——希望不是后者,畢竟之前蘋果的外包維修商 Pegatron 就出過惡意泄露用戶隱私照片的嚴重事故。

4)這樣的檢測系統,其實很容易通過簡單的方法逾越。

那些傳播兒童色情內容的犯罪嫌疑人,可以更換其它通訊軟件,抑或對圖片進行簡單的修改(比如加上帶有微弱遮蓋效果的字幕),就可以讓一張圖片的哈希值“面目全非”。

圖片來源:Jens Segers

圖片來源:Jens Segers綜合考慮到前面所有提到的關于這個系統的弊端,得出的結論是:它打開的隱私缺口太大,制約兒童色情內容傳播的實效卻無法保證。說好聽,事倍功半;說難聽點,反而會弄巧成拙。

你怎么看蘋果這次“偷看用戶照片”的反兒童色情內容傳播系統?你覺得它會起到多大的幫助?你會擔心它對端到端加密和用戶隱私帶來的負面效應嗎?歡迎在留言中分享你的看法。

注:封面圖來自于 Chris Velazco 的 Twitter 賬號,版權屬于原作者。如果不同意使用,請盡快聯系我們,我們會立即刪除。

(聲明:本文僅代表作者觀點,不代表新浪網立場。)