在游戲里還原自己的臉,給AI一張照片就行,網易&密歇根大學出品 | AAAI 2021

來源:量子位

魚羊 發自 凹非寺

量子位 報道 | 公眾號 QbitAI

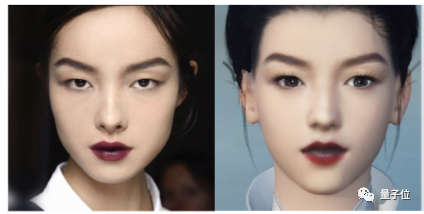

給AI一張毛不易的照片,它自動就能生成一個古風毛大俠。

小姐姐冷艷的氣質,可以被還原出一代俠女風范。

也可以探索一下,奧巴馬穿越回宋朝是一種怎樣的體驗……

現在,想在游戲里定制化自己的臉,你可以不用自己花時間琢磨參數了。

熟悉游戲的小伙伴可能認出來了,這一套AI捏臉術,來自網易伏羲人工智能實驗室和密歇根大學。

現在,最新相關研究登上了AAAI 2021。

據作者介紹,這個名為MeInGame的方法,可以集成到大多數現有的3D游戲中,并且相比于單純基于3DMM(3D Morphable Face Model )的方法,成本更低,泛化性能更好。

具體實現細節,一起來看。

方法原理

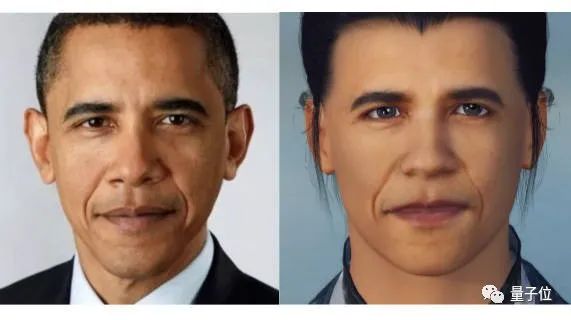

研究人員將人臉形狀和紋理的重建,視作一個自監督的面部相似度測量問題。

首先,對于輸入照片,預先訓練好的形狀重建器會預測其3DMM和姿勢系數,并在保持拓撲結果的同時,將3DMM網格轉換成游戲網格。

這么做的原因,是3DMM網格的拓撲結構與大多數游戲中使用的網格不同。直接基于3DMM來從單張圖像中還原出游戲中的3D人臉,需要大量的人臉紋理數據進行訓練,費時費力不說,實驗室條件下收集的數據也可能出現泛化不佳的問題。

接著,基于游戲網格,將輸入圖像解包到UV空間,創建一個粗紋理圖。紋理會由一組編碼器-解碼器模塊進行進一步細化。

另外,研究人員還設計了光照歸回器。這是一個輕量級網絡,由幾個完全連接層組成,能根據圖像特征預測光照方向、環境光、漫反射、高光等光照系數。

最后,將預測出的形狀、紋理和光照系數一起反饋給可微分渲染器,在結果與輸入的人臉照片相似的情況下,驅動2D人臉渲染。

研究人員還引入了兩個判別器,來進一步改善結果。

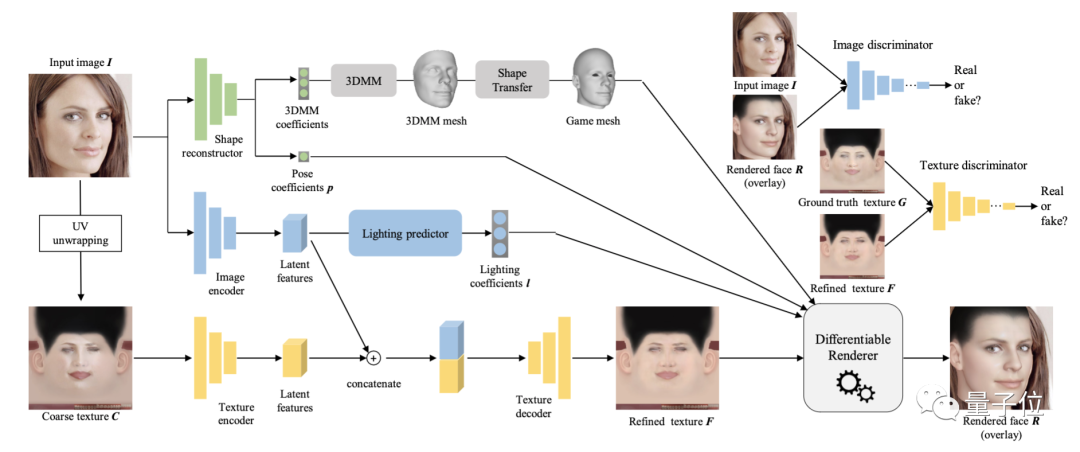

具體到數據集的準備方面,這項研究提出了一種低成本面部紋理采集方法:與其他需要多視角圖像的方法不同,只使用單視角圖像,因此更加容易獲取。

步驟如下:

對于輸入的人臉圖像,使用預訓練人臉分割網絡檢測皮膚區域;

計算輸入人臉皮膚的顏色均值,并將均值遷移到模板紋理圖(由游戲開發者提供);

根據游戲網格,將輸入的人臉圖像進行解包到UV空間。

使用泊松混合,將解包后的圖像與模板紋理圖進行融合。移除頭發、眼鏡等非皮膚區域,并盡可能利用對稱性補齊遮擋區域。

實驗結果

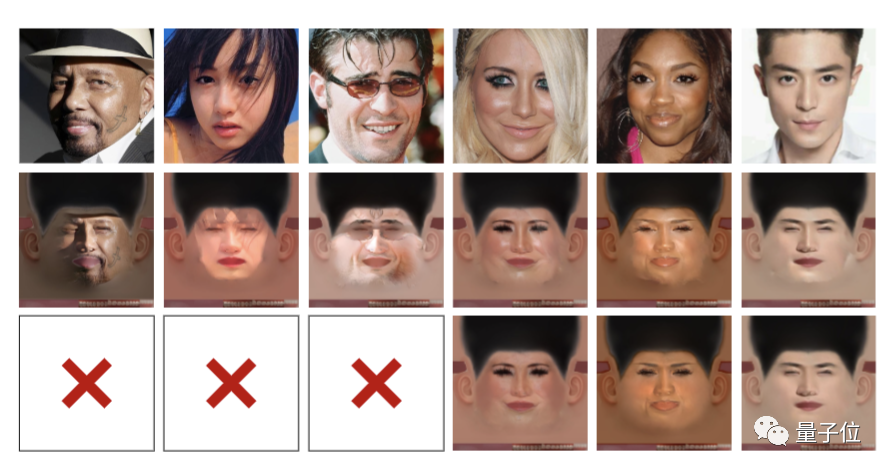

所以,網易伏羲實驗室&密歇根大學的MeInGame,跟前輩方法們相比有何優勢?

從與A Dream of AI、Loomie、ZEPETO等方法的定性比較結果來看,該方法無論是在面容(包括膚色)的還原度上,還是妝面這樣的個性化細節上,都要略勝一籌,并且能消除光照和遮擋的影響。

而基于3DMM的方法雖然能夠高度還原真實人臉,但其建模不包括完整的頭部模型及紋理,很難直接用于游戲環境。

根據論文信息,相關代碼和數據集,將會在GitHub上釋出。

傳送門

論文地址:

https://arxiv.org/abs/2102.02371

GitHub地址:

https://github.com/FuxiCV/3D-Face-GCNs

(聲明:本文僅代表作者觀點,不代表新浪網立場。)