人工智能大模型的興起,讓英偉達公司成為全球最受關注的企業之一。最近,英偉達首席執行官黃仁勛宣布:Rubin將是Blackwell芯片的后繼平臺。今年3月18日,這家硅谷企業發布了Blackwell芯片平臺,剛進入生產階段。為何在兩個多月后,就急著官宣下一代還在研發的人工智能芯片?人工智能芯片技術和產業的發展趨勢是什么?解放日報·上觀新聞記者采訪了上海硅知識產權交易中心總經理、上海市集成電路行業協會監事長徐步陸博士。

對GPU應用前景“先知先覺”

據介紹,人工智能芯片以GP-GPU通用計算芯片為主體。GP的意思是通用,GPU的本意是圖形處理器,所以GP-GPU的全稱為“通用圖形處理單元”,簡稱GPU。正是因為在這個芯片領域做到世界第一,英偉達才超越英特爾,成為全球最炙手可熱的芯片公司。GPU在個人電腦、手機和平板電腦里就有,用來處理與圖像相關的運算。這類芯片有并行計算功能,能夠在同一時間做大量比較簡單的運算,在人工智能大規模計算上大有用武之地。憑借對這一應用前景的“先知先覺”,黃仁勛帶領團隊將GPU升級為GP-GPU,讓這類芯片更適合高性能并行計算,并能使用更高級別的編程語言。

隨著人工智能產業的興起,高性能GP-GPU的應用價值越來越大。這類芯片主要應用在人工智能模型訓練與推理、高性能計算兩大領域。在大模型訓練中,用于訓練的GPU往往部署在云端,即安裝在服務器里,注重絕對的計算能力;用于推理的GPU則注重綜合指標,用于云端或設備端,需通盤考慮單位能耗算力、時延、成本等因素。在高性能計算領域,GPU也扮演著重要角色,用于數據中心、科學計算、自動駕駛等多種應用場景,能執行海量數據的并行計算。

英偉達產品是芯片級服務器

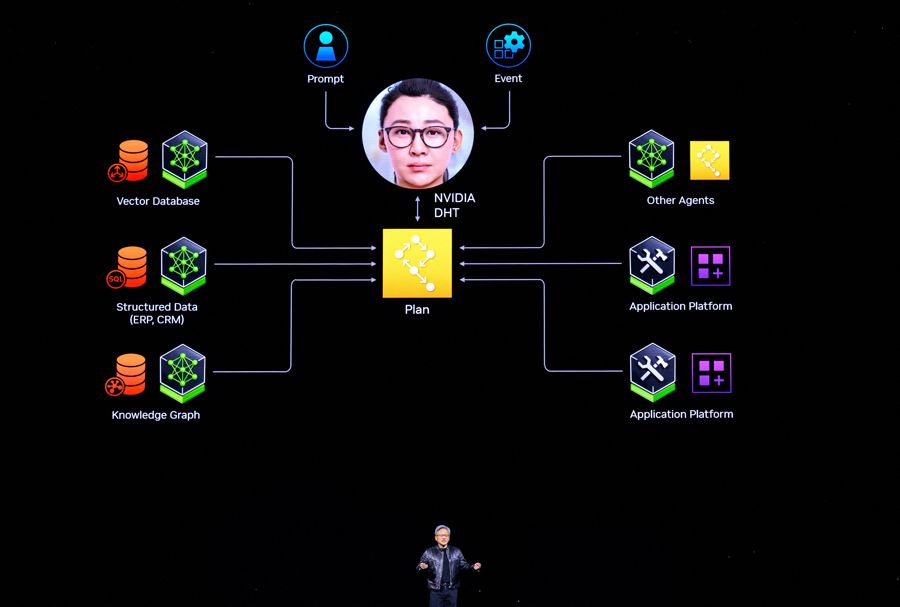

“很多人對人工智能芯片有個誤解,以為有了GPU,就不需要CPU了。”徐步陸說,“其實,GPU和CPU各有所長。簡單講,前者擅長并行計算,后者有復雜邏輯的控制功能。”以英偉達今年3月發布的GB200芯片為例,它由兩個B200 Blackwell GPU和一個基于Arm公司芯片架構的Grace CPU組成,采用臺積電4納米工藝制程,包含2080億個晶體管,其性能達到每秒20千萬億次浮點運算。GPU與CPU、存儲器等不同種類裸片集成為單顆芯片,稱為芯片級“異構”。在存算一體化過程中,合理優化分配GPU、CPU、加速單元等異構處理器、存儲和傳輸之間的任務和負載,是人工智能芯片技術發展的一個趨勢。黃仁勛最近宣布在研的Rubin芯片,將配備新一代GPU、基于Arm架構的Vera CPU以及HBM4高帶寬存儲器,就體現了這一趨勢。“從本質上看,英偉達做的產品不單是芯片,而是芯片級服務器,為客戶提供‘片上計算系統’等智能計算解決方案。”徐步陸告訴記者。

提前官宣有利于產業鏈協同

在服務器領域,英偉達為谷歌、微軟、亞馬遜等云服務巨頭企業供貨,同時也對這些傳統巨頭形成了挑戰。另外,英偉達也要應對AMD、英特爾等芯片企業向它發起的挑戰。在這種激烈的市場環境中,黃仁勛在發布Blackwell芯片平臺后的三個月內,急著官宣下一代人工智能芯片,也就不難理解了。顯然,適時推出人工智能硬件產品路線圖和時間表,可以給予產業鏈、供應鏈上下游企業一個比較明確的預期,讓它們根據路線圖和時間表盡早謀劃自身產品。超前官宣下一代人工智能芯片,還能引起資本市場的關注,有助于英偉達維持3萬億美元這一科技公司的歷史性市值,籌集到更多的研發經費。徐步陸指出,集成電路產業在全球資本的保障下,處理器、存儲器、傳輸光模塊等芯片在設計上越來越同步,芯片設計與尖端制程的晶圓制造、三維立體封裝正在形成高效協同,算力芯片與傳輸協議、開發環境的協同性也越來越高。

在協同性方面,人工智能芯片與通用并行計算架構生態系統的優化協同值得一提。英偉達開發的CUDA,就是一個通用并行計算架構生態系統。它包含CUDA指令集架構和GPU內部的并行計算引擎。軟件工程師可以用C語言來為CUDA架構編寫程序,讓這些程序在支持CUDA的處理器上高性能運行。

“這是一個編程平臺、應用框架和基礎架構。”徐步陸解釋,“通過軟件和硬件產品的協同,英偉達打造了強大的GPU創新生態,吸引全球用戶在這個生態里開發AI產品并優化開發工具、算子庫等,從而越用越好用,以致產生用戶依賴性。”

放眼國內,華為等一批人工智能芯片頭部企業也在開發生態系統。雖然目前國產生態系統的用戶數量不如CUDA,但國內集成電路業界已達成一種共識:只有加快構建開放式新一代人工智能芯片軟硬件一體化生態,中國集成電路和人工智能產業才能實現自主可控、面向全球的可持續發展,也能更好地為各行業培育新質生產力服務。

原標題:黃仁勛為何急著官宣英偉達下一代人工智能芯片?|新科普

VIP課程推薦

APP專享直播

熱門推薦

收起

24小時滾動播報最新的財經資訊和視頻,更多粉絲福利掃描二維碼關注(sinafinance)