GPT-3數(shù)學(xué)不及格,愁壞伯克利團(tuán)隊(duì),于是他們出了12500道數(shù)學(xué)作業(yè)

來源:量子位

賈浩楠 發(fā)自 凹非寺

量子位 報(bào)道 | 公眾號 QbitAI

GPT-3,是個嚴(yán)重偏科的“文科生”。

UC伯克利的研究人員,在對類似GPT-3的大型語言模型進(jìn)行測試后發(fā)現(xiàn),數(shù)學(xué),就是這類AI的盲區(qū)。

12500道高中數(shù)學(xué)題,GPT-3的正確率最低不到3%,最高也沒超過7%。

完全不合格啊~

一直以“全知全能”形象示人的GPT-3,在面對數(shù)學(xué)問題時卻一臉懵逼,這怎么能行?

于是,伯克利的團(tuán)隊(duì),就量身為大語言模型打造了一個數(shù)學(xué)問題數(shù)據(jù)集。

“文科生”的數(shù)學(xué)作業(yè),終究還是逃不掉。

為啥要讓AI學(xué)數(shù)學(xué)?

AI學(xué)了數(shù)學(xué)有啥用?

數(shù)學(xué)是所有科學(xué)的基礎(chǔ),模擬行星軌道、原子運(yùn)動、棋牌游戲等等本質(zhì)都是數(shù)學(xué)問題。

去年大火的AlphaFold,生成預(yù)測蛋白質(zhì)結(jié)構(gòu),本質(zhì)也是復(fù)雜數(shù)學(xué)問題求解。

此外,AI解數(shù)學(xué)題時對不同解題方法的選擇組合,也是衡量算法能力的參考。

所以,即便GPT-3平時面對的多是文本任務(wù),但讓它去學(xué)數(shù)學(xué),依然有助于人們弄明白超大模型處理數(shù)學(xué)推理任務(wù)的特點(diǎn)。

之前的研究已經(jīng)證明,牢固掌握數(shù)學(xué)概念對AI很重要。

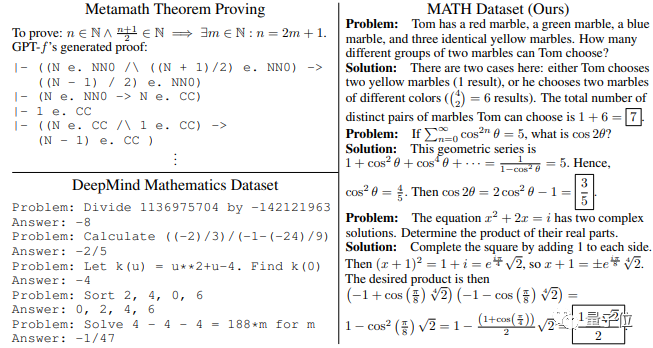

例如,OpenAI最近推出了GPT-f,這是Metamath形式化語言的自動證明器和證明助手。

GPT-f對一些數(shù)學(xué)問題做出的證明,已經(jīng)被Metamath主庫所接受,這是AI的數(shù)學(xué)論證第一次數(shù)學(xué)社區(qū)所采用。

Facebook方面也聲稱已經(jīng)成功實(shí)驗(yàn)了數(shù)學(xué)AI算法。在去年1月的一篇博客文章中,該公司的研究人員表示,他們已經(jīng)教會了一個模型將復(fù)雜的數(shù)學(xué)方程視為一種語言,然后將解題過程視為翻譯問題。

鑒于此,伯克利的團(tuán)隊(duì)創(chuàng)建了數(shù)學(xué)問題數(shù)據(jù)集MATH,其中包括12500道來自高中數(shù)學(xué)競賽的習(xí)題。

果然,AI現(xiàn)在也躲不過數(shù)學(xué)競賽了。

MATH能起到什么用?

MATH的12500道數(shù)學(xué)題,來自包括 AMC10、AMC12、AIME 等等競賽。其中許多問題是從 aops社區(qū)收集的。

這些競賽題跨越了幾十年歷史,主要目的是評估數(shù)學(xué)人才的問題解決能力。

所以,MATH與之前所有類似數(shù)學(xué)數(shù)據(jù)集不同,大多數(shù)問題不能通過簡單地應(yīng)用標(biāo)準(zhǔn)K-12數(shù)學(xué)工具來解決。

無論是人還是AI,必須通過活用數(shù)學(xué)知識和“啟發(fā)式”的推理手段才能得到答案。

△

△不同數(shù)據(jù)集中數(shù)學(xué)問題對比

12500個問題中,包括7500個訓(xùn)練問題,和5000個測試問題。

其中的范圍,包括代數(shù)、微積分、統(tǒng)計(jì)、幾何、線性代數(shù)、數(shù)論等等。

在每個子領(lǐng)域下,相關(guān)問題涉及幾乎所有重要定理和公式.

比如多項(xiàng)式展開、三角形面積、冪級數(shù)展開…..

而MATH與以往所有數(shù)學(xué)數(shù)據(jù)集最大的不同,就是它的每一個訓(xùn)練問題下,都有清晰的解題步驟和公式依據(jù)。

訓(xùn)練后的模型,可以學(xué)習(xí)到許多有用的啟發(fā)式解決問題的思路。

除了MATH,團(tuán)隊(duì)還推出了一個龐大而多樣化的數(shù)學(xué)預(yù)訓(xùn)練語料庫AMPS。

AMPS的Khan子集有693個練習(xí)類型,超過100,000個問題,基本上是K-12教學(xué)中常用的。問題類型從初級數(shù)學(xué)(如加法)到多變量微積分(如斯托克斯定理),并用于教授實(shí)際的K-12學(xué)生.

團(tuán)隊(duì)還貢獻(xiàn)了自己的Mathematica腳本,生成了約500萬個的問題。

這個超過23GB大小的數(shù)據(jù)集,是專門用來訓(xùn)練超大模型用的。其中的問題包括代數(shù)、微積分、計(jì)數(shù)和統(tǒng)計(jì)學(xué)、幾何學(xué)、線性代數(shù)和數(shù)論的各個方面。

與之前的算法生成數(shù)學(xué)問題的方法不同,由于使用了Mathematica的計(jì)算機(jī)代數(shù)系統(tǒng),這樣使用者就可以直接對分?jǐn)?shù)、分析函數(shù)等等進(jìn)行操作。

AI的數(shù)學(xué),及格了嗎?

盡管是高中競賽題,但難度依然不小。

團(tuán)隊(duì)特地用MATH對人類進(jìn)行了評估,結(jié)果,一名計(jì)算機(jī)科學(xué)博士學(xué)生的答題正確率為40%。

一位三次獲得IMO金牌的人成功率達(dá)到了90%,這表明MATH對人類也具有挑戰(zhàn)性.

而在對AI進(jìn)行訓(xùn)練測試后,發(fā)現(xiàn)成績依然不理想。

數(shù)據(jù)集中的分步解決方案,能讓語言模型像人類數(shù)學(xué)家一樣使用 “短期記憶”。

即模型不必馬上得出正確答案,而是可以逐步探索解法一步步走向正確答案。

但即使有了解決方案,研究者發(fā)現(xiàn),對于GPT-2和GPT-3來說,準(zhǔn)確率仍然很低.

從上圖結(jié)果中能看出,讓模型在產(chǎn)生答案之前生成自己的解決方案,實(shí)際上降低了準(zhǔn)確性。因?yàn)樵谠S多錯誤案例中,盡管解題步驟與問題相關(guān),但它們是不合邏輯的。

此外,簡單地增加模型中的訓(xùn)練時間和參數(shù)數(shù)量,有時會提高性能。但事實(shí)證明,這樣做的代價(jià)過于高,訓(xùn)練的時間和能耗都大大增加。

而在AMPS上進(jìn)行預(yù)訓(xùn)練可將準(zhǔn)確率提升約25%,這相當(dāng)于將模型大小提高15倍。

所以,盡管惡補(bǔ)了12500道高中數(shù)學(xué)競賽題,GPT-3還是不及格。

但研究人員認(rèn)為,讓AI學(xué)會分步解題仍然有進(jìn)步意義。

與直接在問題和答案上進(jìn)行訓(xùn)練相比,MATH上訓(xùn)練過的模型,可以提高10%的相對準(zhǔn)確率。

最重要的,是模型“掌握”了一些基本數(shù)學(xué)知識。在一些錯誤的解法下,AI已經(jīng)懂得調(diào)用相關(guān)的公式定理,而不是胡言亂語一通。

AI數(shù)學(xué)競賽的第一課,并不是毫無收獲。

GPT-3也不要灰心,伯克利的團(tuán)隊(duì)說了,隨著對模型的改進(jìn),今后它們的數(shù)學(xué)推理能力會越來越強(qiáng)。

MATH和AMPS現(xiàn)在都已開源,有興趣的研究者可以直接下載:

https://github.com/hendrycks/math/

(聲明:本文僅代表作者觀點(diǎn),不代表新浪網(wǎng)立場。)