這個AI“大師級”簡筆畫水平,驚艷到了網友:竟然不用GAN

來源:量子位

金磊 發自 凹非寺

量子位 報道 | 公眾號 QbitAI

AI畫的簡筆畫能到什么水平?

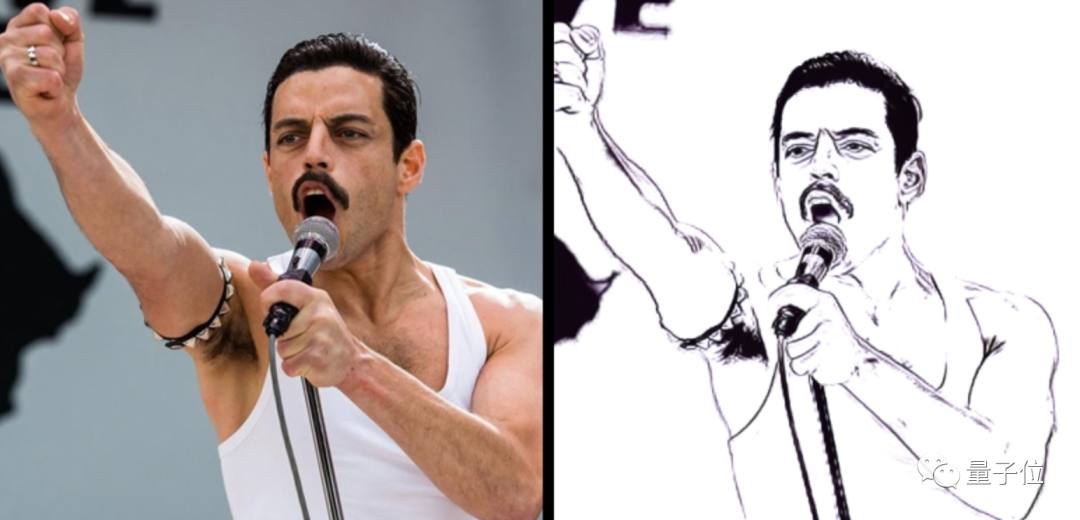

給一張美國演員Rami Malek的照片,效果是這樣的。

是不是和原圖很逼近了?

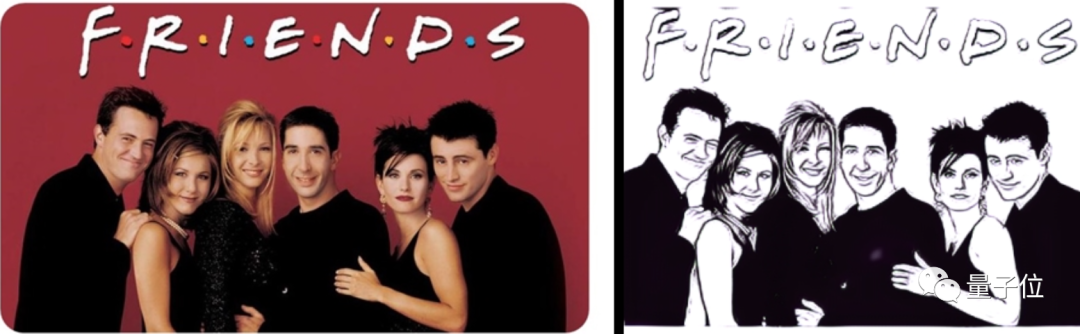

再來看下輸入《老友記》合影的效果。

雖然人物眾多,但出來的簡筆畫效果,依舊還是能分清劇中的人物。

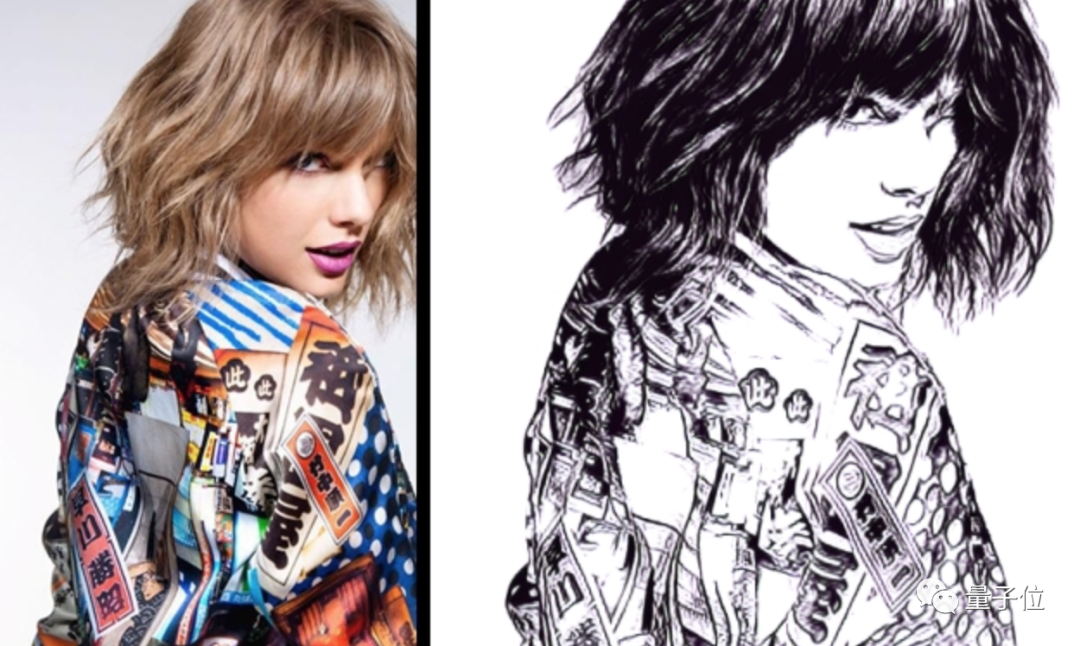

如果毛發特別濃密的人物照,AI還能hold得住嗎?

小姐姐“爆炸頭”的邊緣毛發,也算得上是完美還原了。

再近距離一些的呢?來看“霉霉”(Taylor Swift)照片的效果。

可以說是相當的細節了,把發絲的層次感、光感,以及衣物的褶皺,都發揮的“淋漓盡致”。

……

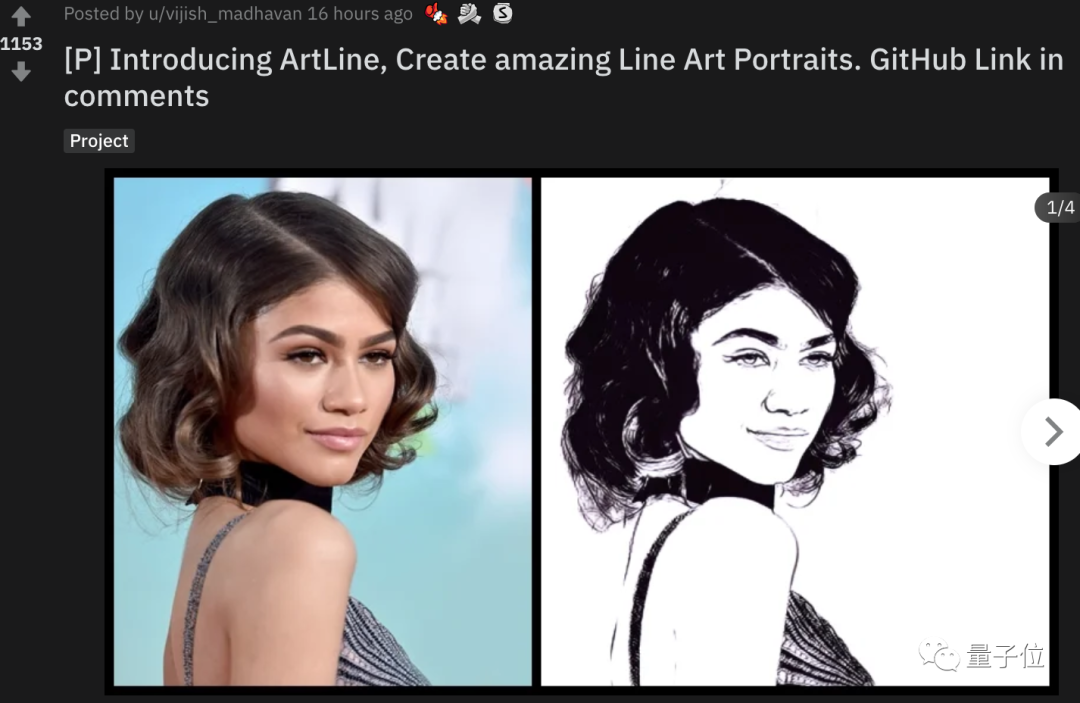

這些就是出自一個叫ArtLine的AI的作品。

而且它在Reddit非常火爆,已經達到了1100+的熱度。

如此惟妙惟肖的效果,你是不是認為又是GAN的功勞?

錯!

ArtLine完全沒有用到GAN:

也正因如此,ArtLine的效果真真兒的驚艷到了網友。

那么,它是如何做到的呢?

ArtLine背后的三大“法寶”

ArtLine的作者十分爽快地分享了其背后的三大技術:

Self-Attention

Progressive Resizing

Generator Loss

接下來,一起逐一看下各個技術背后的細節內容。

Self-Attention部分引用的技術,出自兩年前GAN之父lan Goodfellow等人提出的研究。

等等,剛才不是還說“沒用到GAN”嗎?

作者對此的解釋是:

并沒有起到太大作用。

這項研究主要是在GAN生成中加入了注意力機制,同時將SNgan的思想引入到生成器當中。

所要解決的是傳統GAN自身存在的一些問題,例如:

使用小的卷積核很難發現圖像中的依賴關系

使用大的卷積核就會喪失卷積網絡參數與計算的效率

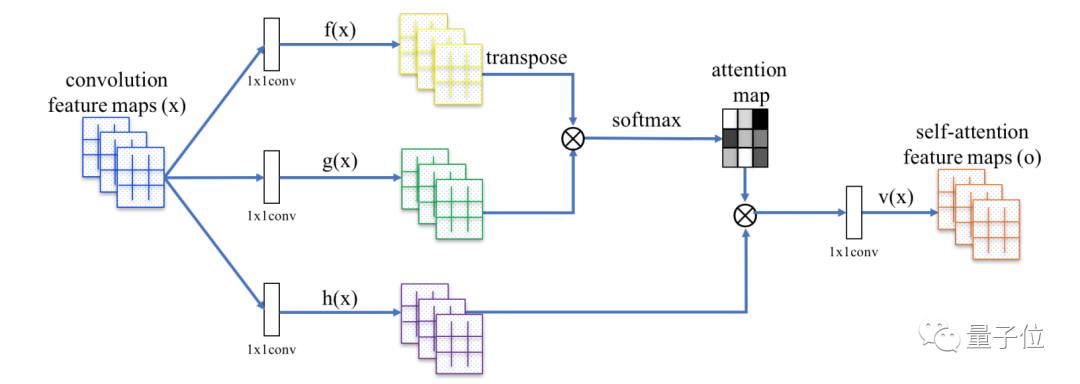

研究中核心的自注意力機制如下圖所示。

其中,f(x),g(x)和h(x)都是普通的1x1卷積,差別只在于輸出通道大小不同。

而后,將f(x)的輸出轉置,并和g(x)的輸出相乘,再經過softmax歸一化,得到一個Attention Map。

得到Attention Map之后,和h(x)逐像素點相乘,得到自適應的注意力feature maps。

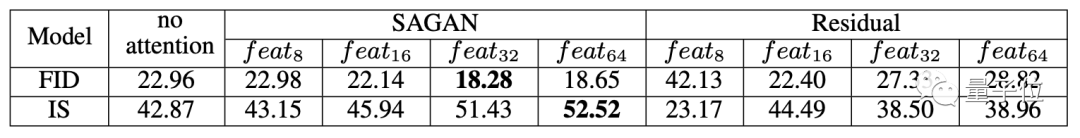

從結果上來看,引入自注意力機制的效果,確實在FID和IS兩個性能指標下,得到了較好的效果。

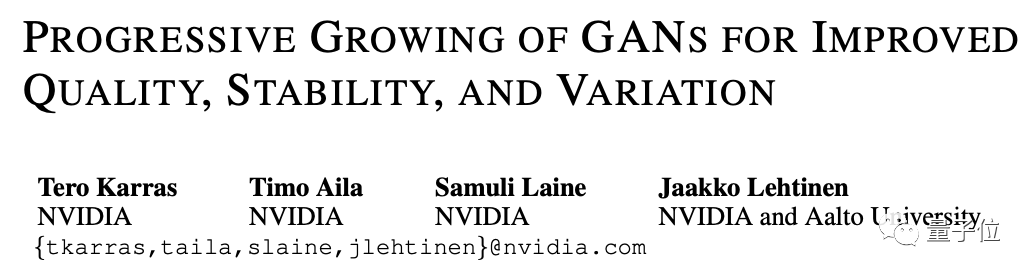

ArtLine涉及到的第二個技術靈感,來自英偉達在2018年的一項研究。

這項研究主要提出了一種新的訓練對抗神經網絡的方法。

核心思想是逐步訓練生成器和判別器:從低分辨率開始,隨著訓練進程推進,逐步增加新的層來提煉細節。

這種方法不僅加快了訓練速度并且更加穩定,可以產生高質量的圖像。

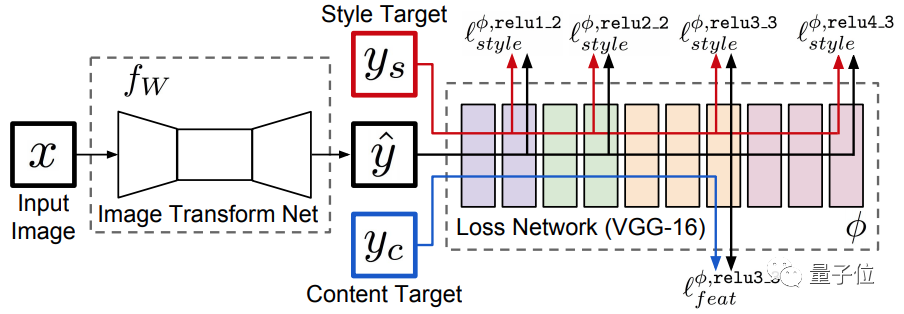

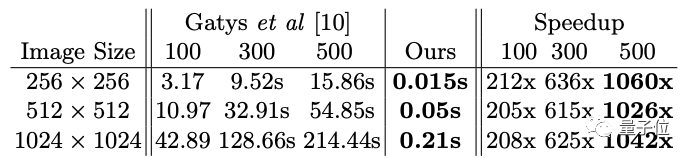

ArtLine所涉及到的最后一個技術,是來自斯坦福大學李飛飛團隊在2016年提出的研究。

這項研究主要解決了實現的風格轉換,比較費時的問題。

風格轉換部分主要用了上面的網絡模型,這個模型可以分為兩部分:左側是圖像轉換網絡,而右側是損耗網絡。

其超分辨率重建也是采用上面的網絡模型,只是具體內部的圖像轉換網絡部分稍有區別。

這個網絡與之前的研究相比,效果達到了相當的水平,但速度卻提升了百倍之多,達到3個數量級。

關于作者

ArtLine的項目作者叫做VijishMadhavan。

他在GitHub中坦言自己并非程序員出身,也道出了ArtLine目前存在的一些缺陷,例如處理像素低于500px的圖像時,效果并不理想等。

現在,ArtLine可以在線玩了!

Colab鏈接:

https://colab.research.google.com/github/vijishmadhavan/Light-Up/blob/master/ArtLine(Try_it_on_Colab).ipynb.ipynb)

https://colab.research.google.com/github/vijishmadhavan/Light-Up/blob/master/ArtLine.ipynb

GitHub項目地址:

https://github.com/vijishmadhavan/ArtLine

本文系網易新聞?網易號特色內容激勵計劃簽約賬號【量子位】原創內容,未經賬號授權,禁止隨意轉載。

AI落地最佳參考!

2020中國人工智能年度評選結果揭曉

12月16日,量子位MEET 2021智能未來大會現場,50大領航企業、10大明星創業公司、30大商業領軍人物、10大最佳產品、10大最佳解決方案、5大社會責任榜樣、5大最佳技術社區等年度獎項悉數頒出。

量子位?QbitAI · 頭條號簽約作者

?'?' ? 追蹤AI技術和產品新動態

一鍵三連「分享」、「點贊」和「在看」

科技前沿進展日日相見~

(聲明:本文僅代表作者觀點,不代表新浪網立場。)