谷歌發布最新元學習框架「DVRL」,用強化學習量化模型中每個數據點的價值

你是否還在使用大規模數據集進行無腦訓練呢?

實際上,如果數據集包含低質量或標簽不正確的數據,通常可以通過刪除大量的訓練樣本來提高性能。

此外,如果訓練集與測試集不匹配(例如,由于訓練和測試位置或時間的差異) ,人們還可以通過將訓練集中的樣本限制為與測試場景最相關的樣本,從而獲得更高的性能。

由于這些場景的普遍存在,準確量化訓練樣本的值對于提高真實數據集上的模型性能具有很大的潛力。

除了提高模型性能之外,為單個數據分配質量值(quality value)也可以啟用新的用例,也可以用來提出更好的數據收集方法。

例如,什么類型的附加數據最有利,并可用于更有效地構建大規模的訓練數據集,或者使用標簽作為關鍵字進行網絡搜索,過濾掉不太有價值的數據。

量化數據的價值

對于給定的機器學習模型,并不是所有的數據都是相等的。一些數據與手頭的任務有更大的相關性,或者相比其他數據有更豐富的信息內容。

那么,到底該如何評估單一數據的價值呢?在完整數據集的粒度上,人們可以簡單地在整個數據集上訓練一個模型,并將其在測試集上的性能作為數據的價值。

然而估計單一數據的價值要困難得多,特別是對于依賴于大規模數據集的復雜模型,因為在計算復雜度上來說,不可能對一個模型的所有可能的子集進行重新訓練和評估。

為了解決這個問題,研究人員探索了基于排列的方法(例如:influence functions)和基于博弈論的方法(例如:data Shapley)。

然而,即使是當前最好的方法也遠不能適用于大型數據集和復雜模型,而且它們的數據評估性能也是有限的。

同時,基于元學習(meta learning)的自適應權重分配方法已經被開發出來,用來使用元目標(meta-objective)估計權重值。

但是他們并沒有優先考慮從高價值的數據樣本中學習,而通常是基于梯度下降法學習或者其他啟發式方法得到數據價值的映射。這些方法改變了傳統的預測模型的動態訓練,會導致與單個數據點的價值無關的性能變化。

使用強化學習評估數據(DVRL)

為了推斷數據值,我們提出了一種數據值估計器(DVE) ,該估計器用來估計數據值,并選擇最有價值的樣本來訓練預測器模型。

這種操作基本上是不可微的,因此不能使用傳統的基于梯度下降的方法。

相反,Google的研究員們建議使用強化學習(RL) ,這樣 DVE 的監督是基于一個獎勵Reward,而這個Reward能用來量化預測器在一個很小但干凈的驗證集上面的性能。

DVRL:Data Valuation Using Reinforcement Learning

在給定狀態和輸入樣本的情況下,Reward指導Policy進行最優化選擇,向著最優的數據價值方向進行。

Google AI 研究院以預測模型學習和評估框架為環境,提出了一種新的基于實例推理的機器學習應用方案。? ? ??

實驗結果

結果評估了 DVRL 在不同類型數據集和用例上的數據價值估計的質量。

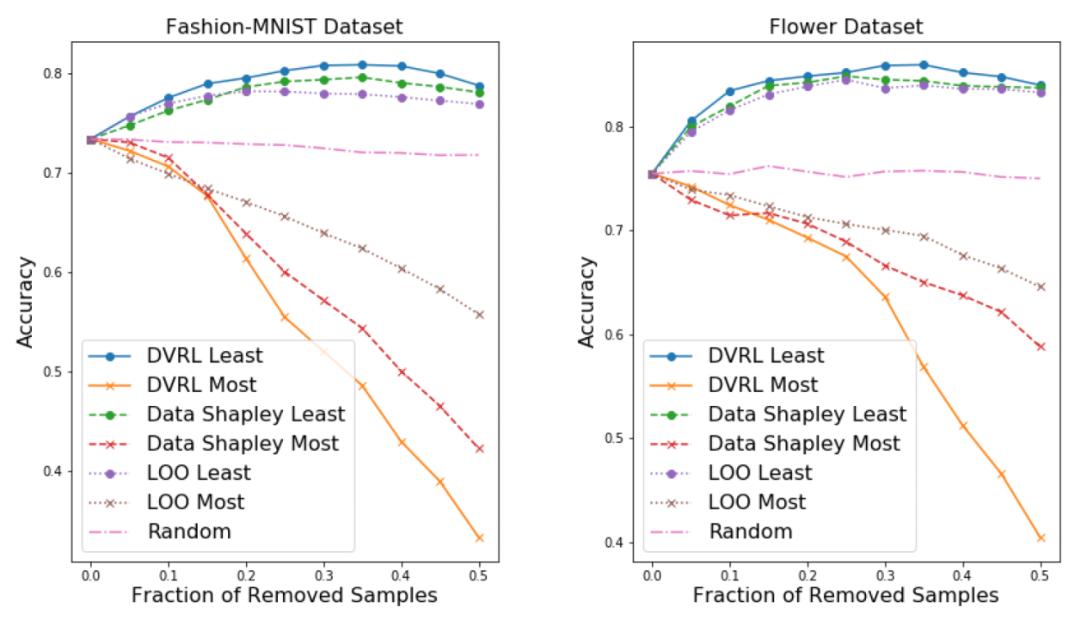

1.去除高/低值樣本后的模型性能:

從訓練集中剔除低值樣本可以提高預測器模型的性能,特別是在訓練集中含有損壞樣本的情況下。

另一方面,移除高值的樣本,特別是當數據集很小時,會顯著降低性能。

總體而言,剔除高/低值樣本后的表現是數據評估質量的一個強有力的指標

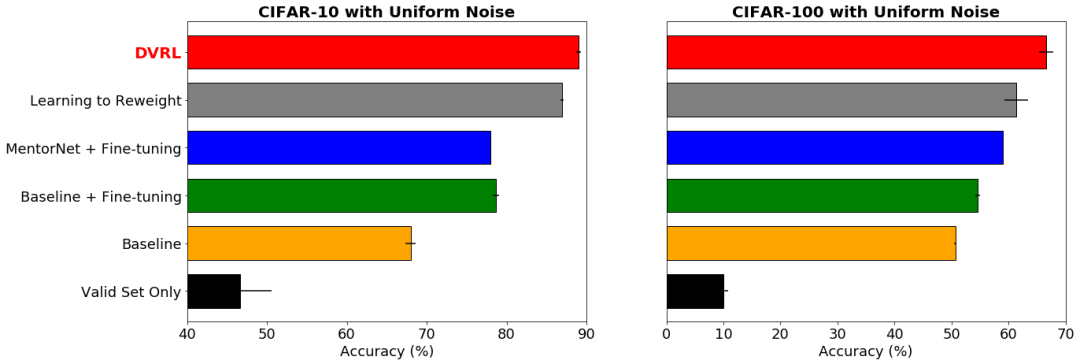

2.帶有噪聲標簽的魯棒學習:

Google AI的研究人員考慮使 DVRL 在帶有噪聲標簽時可以在端到端的方式中學習,而不必刪除低價值的樣本。

理想情況下,噪聲樣本應該得到低數據值,因為 DVRL 會收斂的同時將返回一個高性能模型。

圖:數據集的標簽上有40% 的均勻隨機噪聲,DVRL 優于其他流行的基于元學習的方法

結果顯示,在最小化噪聲標簽影響的情況下,DVRL取得了SOTA的結果。這也表明了DVRL可以應用到復雜模型和大規模數據集。

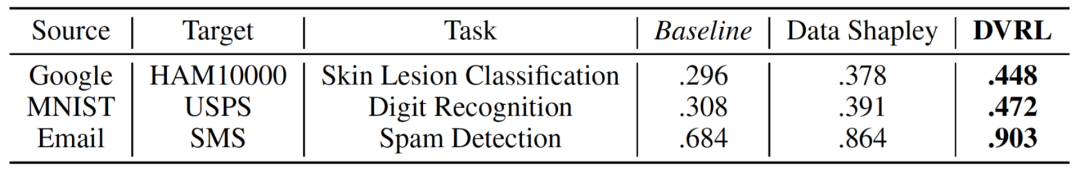

3.領域適應(Domain adaptation):

Google考慮的場景是,訓練集來自與驗證和測試集完全不同的分布。通過從訓練數據集中選擇最適合驗證數據集分布的樣本,數據估值預計將對此任務有所幫助。

DVRL 通過聯合優化數據估值器和相應的預測器模型,顯著提高了領域的適應性。

結論?

Google AI研究院這次提出了一種新的元學習數據評估框架,該框架決定了每個訓練樣本用在預測模型的訓練過程的可能性。

與以往的研究不同的是,該方法將數據評估融入到預測器模型的訓練過程中,使得預測器和DVE能夠相互提高。

通過使用一個經過 RL 訓練的 DNN 對這個數據值估計任務進行建模,并從一個代表目標任務績效的小驗證集中獲得獎勵。

DVRL 以高效的計算方法提供了高質量的排序后的訓練數據,有利于領域自適應、錯誤樣本發現和魯棒學習,同時還發現了 DVRL 在不同類型的任務和數據集上顯著優于其他方法。

參考鏈接:

https://ai.googleblog.com/2020/10/estimating-impact-of-training-data-with.html

(聲明:本文僅代表作者觀點,不代表新浪網立場。)