在2024年美國加州圣荷西的GTC大會上,GPU巨頭英偉達宣布推出號稱目前最強大的AI芯片GB200,并計劃于2024年晚期開始正式出貨。

這款芯片采用了英偉達的最新Blackwell架構,公司創始人兼CEO黃仁勛表示,盡管兩年前推出的Hopper架構GPU表現出色,但英偉達仍需要一款更強大的GPU來滿足市場需求。

英偉達遵循每兩年更新一次GPU架構的策略,以顯著提升AI芯片的性能。繼2022年發布的基于Hopper架構的H100 AI芯片之后,英偉達繼續引領全球AI市場。

現在,搭載Blackwell架構的新AI芯片性能將更加強大,尤其是在處理AI任務方面,該架構得名于數學家David Harold Blackwell。

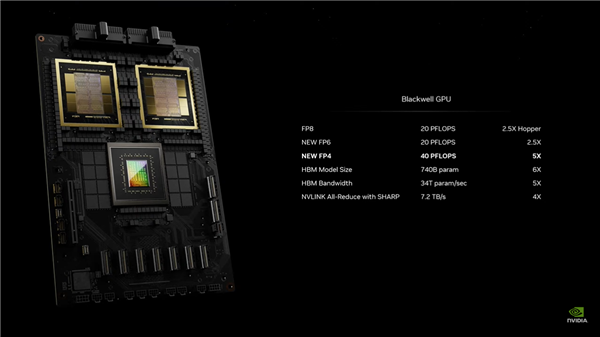

黃仁勛透露,Blackwell架構的AI運算性能在FP8和NEWFP6上可達到20 petaflops,是前一代Hopper架構的8 petaflops性能的2.5倍。

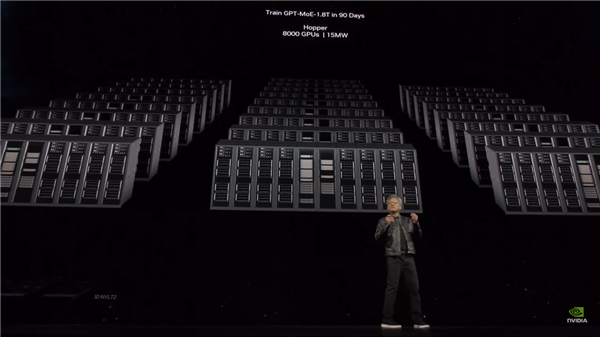

在NEWFP4上,性能更是達到了40 petaflops,是Hopper架構的5倍。根據不同設備配置的內存容量和帶寬,實際性能可能還會更高。這種額外的處理能力將使人工智能企業能夠訓練更大、更復雜的模型。

采用臺積電4納米制程技術的Blackwell架構GPU體積龐大,集成了兩個獨立制造的裸晶(Die),共有2,080億個晶體管,并通過NVLink 5.0接口連接。

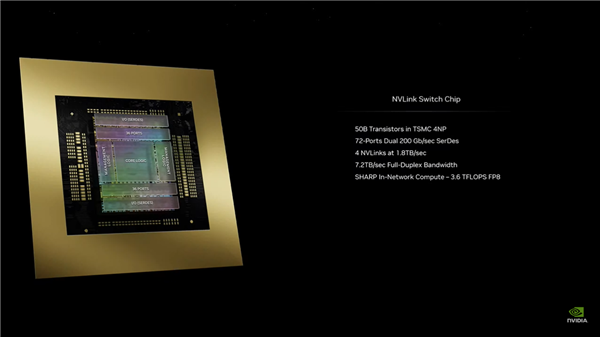

英偉達使用每秒10 TB傳輸速度的NVLink 5.0來連接兩塊裸晶,官方稱該接口為NV-HBI。Blackwell complex的NVLink 5.0接口提供的帶寬高達每秒1.8 TB,是前代Hopper架構GPU上NVLink 4.0接口速度的兩倍。

黃仁勛進一步指出,新推出的GB200 AI芯片包含兩個Blackwell GPU和一個基于Arm架構的Grace CPU。其推理模型性能比H100提升了30倍,同時成本和能耗降低到原來的1/25。

針對有大型需求的客戶,英偉達提供完整的服務器產品,如GB200 NVL72服務器,配備了36個CPU和72個Blackwell架構GPU,以及一套完整的水冷散熱方案,可實現高達720 petaflops的AI訓練性能或1,440 petaflops的推理性能。服務器內部使用的電纜總長度接近2英里,包含5,000條獨立電纜。

目前,亞馬遜的AWS已計劃采購由2萬片GB200芯片組成的服務器集群,能夠部署擁有27兆參數的模型。除了亞馬遜的AWS之外,DELL、Alphabet、Meta、微軟、OpenAI、Oracle和TESLA等也成為了Blackwell系列芯片的采用者。

責任編輯:振亭

“掌”握科技鮮聞 (微信搜索techsina或掃描左側二維碼關注)