谷歌I/O四大更新:科技本質不是硬件和軟件,而是知識與計算

歡迎關注“新浪科技”的微信訂閱號:techsina

文/杜晨

來源/硅星人(ID:guixingren123)

經過三年,谷歌開發者大會 I/O 終于今天回歸線下。

位于谷歌山景城總部旁邊的 Shoreline 露天劇院今天座無虛席。上千名公司員工、合作伙伴代表,以及幸運的第三方開發者,終于在他們最熟悉的地方得以齊聚一堂。

在歡快的電子舞曲之后,谷歌 CEO Sundar Pichai 走了出來:“哈咯,大家能聽到我嗎?”這引得臺下一陣歡笑。

“過去兩年里,每次我進會議都是靜音的,所以我想也許我應該跟大家一起測試一下麥。”

Pichai 表示,今年的 I/O 大會會發布和預告一系列科技含量非常高的產品和功能,橫跨谷歌的搜索、地圖、Android 軟件、Pixel 硬件產品,以及 AI 研究等多個部門。

然而這些產品和功能本身,并不是科技的本質。

幾年前,谷歌重新設計了自己的公司使命:整合全球信息,使人人都能訪問并從中受益。在 Pichai 看來,這個使命有兩個最根本的組成部分:知識和計算。在 Pichai 的帶領下,谷歌在過去幾年內在技術和產品創新方面所做的努力,包括感知計算 (Ambient Computing)、多模態學習、融合搜索 (Multisearch)、超大規模語言模型、增強現實等——其實歸根結底,都是在做兩件事:

1)加深對于信息的理解,將其變為知識;

2)推進計算的范式創新,從而讓任何人在世界任何角落,都可以更容易地訪問和獲取知識。

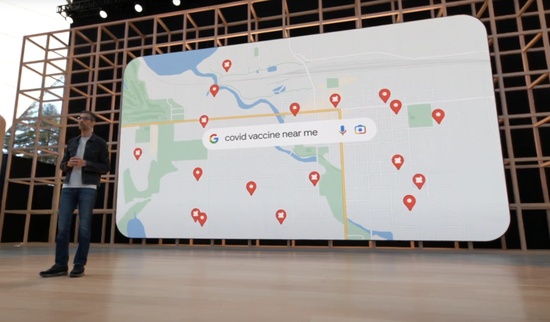

最直接的例子,就是谷歌在過去兩年所扮演重要的信息樞紐角色:

在2021年,人們通過谷歌搜索和地圖來查找疫苗接種信息超過20億次;

在印度和孟加拉國,谷歌采用最新神經網絡技術開發的季風預警系統,已經為超過2300萬人提供了暴雨洪水預警,預計已挽救數十萬災民的生命。

信息只是信息,在民眾之間流轉的效率極低,并且很難保持準確度。但是因為有了先進的知識圖譜技術,這些信息能夠被系統識別、提取、精煉、匯總,最終以搜索結果、手機通知、災害報告等形態,作為一種知識,得到了準確和高效的傳播。

在今天的 I/O 大會,谷歌發布了一系列以推進知識和計算為核心的新產品、功能和技術。

| 讓真實世界可以被"Ctrl-F"

今年4月,谷歌發布了一個全新的多模態搜索功能,讓用戶手機上通過拍照+文本的方式,進行更加定制化的搜索。比如很想買別人穿的一雙鞋,但想要另一款顏色,就可以拍照,再加上“藍色”的文字。這樣,只需要進行一次搜索,就可以更容易地找到自己正在尋找的信息和產品。

但這還不夠。對于谷歌來說,他們想要索引和組織的信息,早已不僅限于網上。比如,我們用谷歌地圖來搜索真實世界中的地理位置相關信息。但如果想要更進一步,讓用戶可以更加精確地搜索真實世界,特別是他們附近的特定信息,能做到嗎?

在今天 I/O 大會上,谷歌還真發布了一個這樣的功能:Multisearch Near Me(周邊多重搜索).

我們可能都遇到過這樣的情況:在網上看到一道之前從未見過,但讓你口水直流的菜,但是你壓根都不知道它叫什么菜,屬于什么菜系,附近有沒有對應的餐館。

這個功能就是專門來解決這個痛點的。你只需要拍照或者把照片上傳,然后文字輸入加上 “在我周圍”:谷歌不僅能告訴你這道菜叫什么名字,還能夠搜到附近有這道菜的店家。

這個搜索能力不僅限于食物,因為它的背后是谷歌搜索已經在采用的多模態機器學習引擎。一個模型可以同時理解并處理文字、圖片、語音等多種不同模態的信息。原則上,任何物體它都能夠搜索,包括并不限于食物、商品、服務(比如美甲)等。

這個功能將于今年內正式推出,初期僅支持英文,后續將會增加更多語言。與此同時,這個功能已經上線谷歌移動端 App,用戶已經可以開始使用。

除此之外,今年谷歌在視覺搜索上面還有另一個大動作:對移動的取景框內,多個不同物體,進行同時和連續搜索,并且通過AR疊加的方式來展現這些物體相關的信息。

比如在超市,面對一整面貨架的咖啡豆,不知道該買哪一款,你只需要掏出手機,打開 Google Lens(谷歌搜索和相機的視覺搜索功能),就可以看到這些不同品牌咖啡豆的評分了。

不僅如此,你還可以繼續進行條件過濾,比如“高分”、“深烘焙”、“不含堅果等”:

這個功能叫做 Scene Exploration,目前仍在開發中,尚無具體發布的計劃。除了 AR 之外,它也同樣利用了剛才提到的多重搜索技術。

Pichai 表示:這就像給真實世界加入了 "Ctrl-F" 功能一樣。

谷歌地圖:觀察真實的世界,現在有了全新角度

疫情兩年以來,很多人恐怕已經忘記旅行是一種怎樣的體驗。這也是為什么很多人現在只能通過谷歌地圖/地球,以及瀏覽各種網站照片和旅行視頻來“過眼癮”。

深知這一點,谷歌地圖團隊決定給用戶們送上一份大福利。

先看下面這張圖。如果不說清楚的話,你可能以為這是一張倫敦實景照片:

但其實,這是谷歌地圖團隊使用最先進的繪圖和機器學習技術,開發出的全新的3D渲染地圖功能 Immersive View:

對于一些知名的地標建筑,比如倫敦的大本鐘和西敏寺大教堂,用戶可以旋轉3D地圖查看不同角度,甚至還可以自選查看地標建筑物在不同時間和天氣下多變的樣貌:

谷歌地圖 Immersive View (沉浸式視圖)將在今年內推出,支持 Android 和 iOS,支持的城市和地標有限,首批包括洛杉磯、倫敦、紐約、舊金山和東京,之后將逐漸增加更多城市和知名建筑物。

AI 幫你“長求總”

在谷歌,Pichai 會要求員工給他發送較長文檔或電郵的時候,把內容總結成 TLDR (Too Long Didn't Read,也就是“長求總”),放在文檔或電郵的最前面。這引發了團隊的思考:如果更多東西也能被 TLDR,那該多好?

之前谷歌還就真的推出過這么一個功能:

在文檔當中,機器學習模型會在后臺運行,從文檔和聊天記錄當中提取文本,提煉出關鍵內容,然后自動生成一份總結:

以下面這份團隊出游計劃為例:AI 可以提取出組織者、成員、每一位成員的登記狀態和提問,以及相關參考資料等重要信息,放在文檔的開頭,讓文檔的參與者可以一目了然。

而在這屆 I/O 大會上,谷歌宣布把這個 TLDR 功能遷移到整個企業套件 Google Workspace 的更多功能里,比如 Space 和 Google Chat。

(Space 是谷歌企業服務的團隊溝通產品,和 Slack 對標。)

畢竟我們可能都有特別喜歡在聊天的時候一句話只發幾個字,還不停的發的同事或朋友——有了這個功能之后,我們也許就可以直接屏蔽ta的消息通知,然后隔段時間看一下總結就行了。

在這個 TLDR 功能的背后,實際上是谷歌在自然語言理解和處理方面的一次“大躍進”式的突破。

在過去,類似的文本總結功能通常需要神經網絡模型同時具有長文本段落理解、信息壓縮和語言生成方面的能力,對于以往的模型來說是不可能的。

隨著谷歌近幾年在超大規模語言模型和多模態機器學習方面的進步,這一看起來非常簡單,正常人可以輕松具備的能力,才終于被機器獲得。

用計算的力量,讓知識無遠弗屆

去年,谷歌推出了 LaMDA (Language Model for Dialog Applications),一個主要用于對話類應用的語言生成模型。我們在去年的 I/O 大會報道中曾經詳細介紹過這個模型。

今年,谷歌在 LaMDA 的基礎上進一步開發,強化了模型的參數量和能力,并終于推出了 LaMDA 2 模型。已經有數千名谷歌員工在試用這一模型并為 Google AI 的研究開發團隊提供反饋。

在此基礎上,谷歌還推出了一個名為 AI Test Kitchen 的測試環境。這是一個應用,目前仍在小范圍封閉測試中,主要目的是讓一小部分人跟它背后的 LaMDA 2 進行對話,提出各種各樣的問題,或者讓它完成各種各樣的任務。

目前 AI Test Kitchen 已經開放了三個 Demo:

1)想象 Imagine it,用戶給出一個地點,讓模型自己想象那里的景色并生成描述:

2)分解步驟/規劃列表 List it,你可以問它一個復雜的問題,比如“把大象裝進冰箱”,然后看它把完成任務需要的步驟列出來。

值得一提的是,分解和生成的步驟列表當中的每一項,還可以繼續分解裂變;而且,它不僅能夠生成列表(提煉知識),還能夠在具體步驟上提供額外的詳細指導(設定幾種不同的具體情況,并提供不同的建議)。

3)描述 Talk About It,給一個既定的話題,讓他隨便說些什么。

目前,LaMDA 模型技術還處于早期階段,在實際試用和完成具體任務的時候會出現一些預料之中或之外的異常情況,比如在用戶意圖繼續討論當前話題的時候出現跑題,或者分解生成的步驟列表存在錯誤信息等。

目前,谷歌搜索和其它一些重度依賴知識圖譜 (Knowledge Graph) 的產品,已經在利用類似的語言生成模型了。通過 AI Test Kitchen,谷歌希望測試者能夠更多地和 LaMDA 進行互動,做出評價,給予反饋。

在未來,谷歌的計劃是采用其在最近一年里開發的超大規模語言模型集大成者——PaLM(全稱 Pathways Language Model)來完成更加復雜的語言模型類任務。

PaLM 和前序超大規模語言模型最大的不同,就在于它有一個“思路鏈條”(Chain of Thought) 系統,并且能夠在輸出結果的時候把這個推理邏輯一同體現出來。這和以往被認為是黑盒子的神經網絡模型工作方式產生了非常大的不同,不僅在 AI 可解釋性上獲得了長足進展,還展現出神經網絡在仿生(人類)的工作機制上的重要進步。

開發超大規模語言模型、多模態神經網絡等目前最先進的機器學習技術,并且將其用于谷歌的核心商業產品,對于這家公司來說尤為重要。

互聯網乃至整個人類社會每天都在生成大量的信息,而谷歌需要維持將這些信息高效地轉變成成為知識,并且讓這些知識可以被每一位用戶及時、方便地獲取的能力。

雖然今天谷歌仍然是世界的百科全書,但只有維持這種能力,谷歌才能繼續實現其當前商業地位和人類社會地位的永續。

One More Thing: 借助 AR 和翻譯的力量,打破語言的隔閡

這場 I/O 大會也發布了不少硬件產品,它們并非我們今天主要關注的對象,你可以通過硅星人的母站品玩的報道來了解這些硬件產品。

不過值得一提的是,還真有一款今天展示的硬件,以它自己獨特的方式,強化了今天谷歌想要傳達的主題。

主題演講的最后,Pichai 播放了一段視頻,展示了谷歌正在開發的一款智能眼鏡原型產品。

這支眼鏡,看起來一點都不“智能”。然而,它卻能夠實時翻譯面前的人所說的話,并且把翻譯結果顯示在鏡片上:

更厲害的是,它還能夠翻譯美國手語 (ASL):

語言是人際溝通最重要的工具。然而,如果對方說的是完全不懂的語言,或者當對方是聾啞人的時候,我們之間的溝通就成了一堵難以跨越的高墻。

在高墻面前,谷歌選擇了它最熟悉的方式——用技術去消弭隔閡,使得難以進行的溝通,終于得以成為可能。

曾幾何時,“科技以人為本”作為一家科技公司的標語,被傳為佳話。而在今天,谷歌更加具體地幫助我們拆解了“科技以人為本”的概念究竟是什么:

科技的本質是知識與計算。而歸根結底,知識與計算的存在,都應該是為了我們更好地理解世界,并被世界所理解。