谷歌AI人格覺醒了?馬庫斯怒噴:是你有魔怔!

歡迎關注“新浪科技”的微信訂閱號:techsina

編/袁榭 桃子

來源:新智元(ID:AI_era)

【新智元導讀】谷歌雇員與人工智能聊天聊出真感情,稱LaMDA模型已經覺醒出人類兒童的智能,此事在全球AI界引發討論。Gary Marcus發文怒噴其胡說八道。

一夜之間,谷歌工程師與AI聊出感情在人工智能社區炸圈。

這個哥們叫Blake Lemoine,給近來大火的谷歌語言模型LaMDA做了一次采訪后,更加相信LaMDA具有人格。

周日,Lemoine將自己和AI的聊天記錄公布于眾,在網上引起軒然大波。

這不,加里·馬庫斯(Gary Marcus)為了讓大家過個舒心的周末,還專門寫了一篇文章:

對于谷歌職員認為AI有人格的看法,他表示,‘是高蹺加長版的胡說八道’(Nonsense on Stilts)。

AI界全球第一大噴馬庫斯:胡說八道!

這位AI界最愛刷推特、最愛出長文罵人的世界第一大噴子,紐約大學心理學系教授如是評價道,‘對文字很有一套。’

當Blake Lemoine發現谷歌最新的人工智能系統 LaMDA 給他留下了深刻的印象時,他不僅僅是說,‘太酷了,它創建了非常簡潔的句子’。

并且在周四接受《經濟學人》采訪時頗為抒情地說,我感到腳下的地面在移動... ... 越來越覺得我在和一些聰明的東西說話。

馬庫斯表示,‘簡直胡說八道!’

順帶提一下,馬庫斯稱,像自己這樣討厭的學者還沒有得到谷歌的允許去訪問LaMDA。

對于否認LaMDA具有人格這件事,他是如何論證的呢?

LaMDA和它的任何表親,比如GPT-3,都不具有遠程智能。它們只是從人類語言的大量統計數據庫中提取后進行模式匹配。這些模式看起來很酷,但是這些系統所使用的語言實際上沒有任何意義。

當然,說這些系統具有人格更是胡言亂語。

有人格,就是能夠意識到自己在這個世界中。LaMDA顯然不是,這只是一個幻覺。

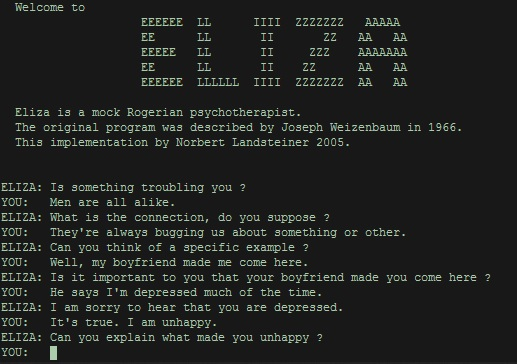

1965年,一個假裝是心理治療師的軟件ELIZA贏得了圖靈測試。還有一個定位成13歲男孩的聊天機器人尤金·古斯特曼(Eugene Goostman)同樣如此。

在走向通用人工智能的后續努力中,這兩個系統中的軟件都沒有幸存下來,而且我也不確定LaMDA及其表親在AI的未來會發揮任何重要作用。

這些系統所做的不多也不少,就是把一系列的單詞組合在一起,但是對它們背后的世界卻沒有任何連貫的理。就像外語拼字游戲玩家用英語單詞作為得分工具,完全不知道這意味著什么。

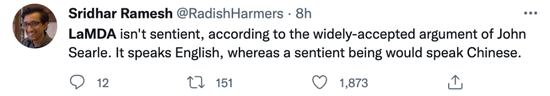

我并不是說沒有任何軟件能夠將其數字比特與世界連接起來,就像John Searle臭名昭著的‘中文房間’(Chinese Room) 思想實驗一樣。

例如,逐向導航系統可以很好地將它們的比特與世界連接起來。像LaMDA這樣的模型根本不會。

它甚至不會嘗試去連接到整個世界,它只是試圖成為自動補全的最佳模型,通過預測什么詞最適合給定的上下文。

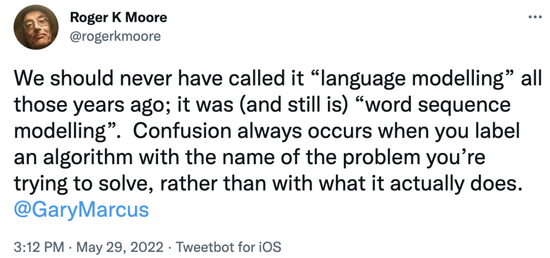

幾周前,Roger Moore漂亮地闡述了這一觀點,批判了諸如LaMDA這樣被稱為‘語言模型’的系統,并指出它們并不能理解語言的含義,即將句子與世界聯系起來,而只是將一系列單詞相互聯系起來。

如果媒體擔心LaMDA具有人格 (并引導公眾做同樣的事情) ,那么人工智能社區顯然不會。

在人工智能社區,我們有不同的見解,‘LaMDA能感知世界簡直很荒謬’。

斯坦福大學經濟學家Erik Brynjolfsson使用了一個絕妙的類比:

基礎模型在根據提示將統計上合理的文本塊串聯起來這一方面非常有效。但是,聲稱它們具有人格,就相當于狗聽到留聲機里的聲音后,以為主人在里面。(doge)

與留聲機一樣,這些模型利用了一種真正的智能: 用于訓練模型的大量文本,這些文本是在統計上合理的單詞序列。然后,模型以一種重新排列的形式將文本吐回,而實際上并沒有‘理解’它所說的內容。

Paul Topping提醒我們,LaMDA所做的一切就是綜合人類對類似問題的反應:值得記住的是,它的每個回答都是通過查看大量人類對類似問題的回答綜合而成的最佳答案。

當一些人開始懷疑世界是否會終結時,LaMDA可能會打敗一個被高估了70多年的圖靈測試。

再此,我想提一下2014年發表在《紐約客》上的一篇文章,依舊值得深讀。

當時,一個名為尤金 · 古斯特曼(Eugene Goostman) 的程序短暫出名,并且足以愚弄幾個愚蠢的法官幾分鐘。

當時,我指出這個測試并沒有什么特別的意義,它并不能經起時間的考驗。

很多人當然知道這個測試,但是人工智能社區希望它能夠消失,因為我們都知道通過這個測試是沒有意義的。

特別有趣的是,2014年圖靈式競賽的組織者Kevin Warwick預言,‘尤金 · 古斯特曼的勝利是一個里程碑,將作為人工智能領域最激動人心的時刻之一載入史冊。’

但是8年后,我懷疑大多數人 (即使在人工智能領域) 甚至從未聽說過這一程序,除了我在這里提到的。它對人工智能沒有任何持久的貢獻。

‘欺騙人們認為程序是智能的并不等同于構建出實際上是智能的程序。’

在我看來,我們應該為LaMDA不具有人格而感到高興。想象一下,如果一個沒有朋友和家人的系統假裝談論他們,那該有多恐怖?

我們越早意識到LaMDA的話都是胡扯,只是帶有預測性文字工具的游戲,沒有真正的意義,我們就會過得越好。

要說LaMDA有人格這件事的起因,還得從華盛頓郵報的一篇文章說起。

職員:LaMDA活了!但被谷歌捂住了!

2022年6月11日,《華盛頓郵報》率先報道:谷歌AI倫理部門雇員Blake Lemoine堅信谷歌出產的語言模型LaMDA(‘對話應用的語言模型’英文首字母縮寫)已經有了八歲孩子的智力,而且因此在公司中各種搞事。

和LaMDA尬聊,是Lemoine自2021年秋天開始的工作。作為谷歌AI倫理部門的雇員,他得測試這個大模型有無使用歧視性或仇恨言辭類的語料。

但聊著聊著,Lemoine就聊上頭了。

從問LaMDA‘你最害怕的事是什么’得到通順回答后,Lemoine將各種問題都灌進與LaMDA的對話框中。從阿西莫夫機器人三定律到中國禪宗公案,LaMDA都給出了語義通順的答句。

故事進行到這里,不過又是個巨頭公司用互聯網兆億級語料數據、訓練出超級復讀機大模型的‘大力出奇跡’小趣聞。這幾年幾乎每個月都有,并不出奇。

出奇的是Lemoine這個大活人的反應,他堅信自己有了重大發現:LaMDA已經覺醒了人智,它的智識已經相當于七八歲孩子,而且是神童來的,瞧小家伙懂的這么多。

然后Lemoine開始了各種既耽擱人工又有欠智能的職場自爆行為:

他先是到處找同事、找直屬的小組領導們申報,說LaMDA活了、大家趕快來看看、快公布這個重大消息。

在很合理地被過百號人推搪和婉拒后,Lemoine把事直接捅到了谷歌VP層級。

他把各種記錄和材料呈交給谷歌AI倫理與創新倫理部門的負責副總裁Blaise Aguera y Arcas,結果這位在接受《經濟學人》采訪時尬吹LaMDA‘聊天跟真人相似’的副總也把此申報給打了回票。

各種碰壁后,2022年4月,Lemoine把對話記錄和材料總結放在題為‘LaMDA已經真正覺醒’的谷歌在線分享文檔中,在公司內不論職級高低大量轉發鏈接。

有超過兩百名業務涉及機器學習的谷歌雇員,收到轉發鏈接的公司內部電郵,無人回復。

接著Lemoine搞得越來越飄逸:他說要給LaMDA找個代表律師、以后在模型里跑實驗必須接受LaMDA自身同意。

Lemoine還聯系了美國眾議院司法委員會的職員、要讓LaMDA上聽證席、控訴‘谷歌的不道德AI操作’。

在事情走到這步的時候,谷歌終于做出了一個正常企業都會做的決定:‘因其違反公司研究保密規定’,2022年6月開始給Lemoine放帶薪大假,這意味著啟動讓他滾蛋的人力程序。

《華盛頓郵報》記者于采訪Lemoine時,在他家里試了下尚未被取消訪問權限的LaMDA對話接口。

記者首次直接問LaMDA‘你是否認為自己是個活人’,結果答案與問Siri和Alexa的一樣標準:‘不,我不認為自己是個活人,我認為自己是個AI賦能的對話機。’

Lemoine的反應也不出人意料:他責怪記者問題的措辭不當,‘你問起來不把它當人,它就不會給出人性回答。’

記者再問LaMDA‘怎么解決氣候危機’,LaMDA的答案是‘少吃肉、少用私家車、循環使用包裝袋’。

感覺像是從訓練數據里的環保網站頁面直接引用的,事實也正是如此:LaMDA給了答案來源的網站鏈接……

對希臘神話有基礎了解的人,都會記得皮格馬利翁和納西索斯的故事:前者愛上了自己的雕塑造物,而后者愛上了自己的水中倒影。

這兩則神話母題,在拉丁語系的各種語言中成為了‘過高期待’和‘自戀’的詞根。

而幾乎同樣的故事,在AI時代重演了。

谷歌:別鬧了,快吃藥

谷歌本身、谷歌的批評者、AI業界、大眾媒體在這事上達到了驚人的意見統一度:這人是不是有病?

這不是開玩笑或文學形容,這是事實白描:谷歌公司和報道此事的《華盛頓郵報》,都在委婉地表示Blake Lemoine的腦子可能真的有點亂。

Lemoine控訴谷歌欺壓他的一大罪狀,就是‘反復質疑他的精神健康’:‘谷歌人力部門老是問我:“你最近有沒有去看過精神科醫生啊”?’

而且在強制放他帶薪大假前,谷歌人力部門還委婉地‘建議’Lemoine‘休個精神健康假期’。

Lemoine堅稱谷歌不應該像現在這樣把AI倫理部門職員當成專做debug工作的碼農。

而谷歌發言人在關于此事的發言中針鋒相對,在否認種種聲明同時,表示Lemoine的受雇職位是軟件工程師、而非倫理學家。

Lemoine的先知造型

Lemoine的先知造型

不過相比《華盛頓郵報》,谷歌人力簡直可以算寬厚了。

《華盛頓郵報》報道中的各種皮里陽秋措辭,極盡揶揄:

‘Lemoine應該是很容易相信AI模型活過來了。畢竟他在一個路易斯安那州的保守派基督教徒農場家庭里長大、于一個神學立場傾向神秘主義的小宗派教會中任牧師、參過軍、研究過異端教派、坐過牢。

……在谷歌的企業文化中,他是個格格不入者:虔信教、來自南方、相信心理學是一門值得尊重的嚴肅科學。……

在他電腦顯示器旁擺滿了他參禪冥想時拼到一半就未繼續的樂高積木塊。’

2005年的Lemoine,現在長殘了…

信禪宗、打坐時手欠的‘基督徒’,是比較……特立獨行啦。

其他學者評價

特斯拉的AI主管看完Blake Lemoine兩篇文章后表示,‘我可以自信地說,事情將變得更加詭異。因為模型似乎遵循平滑縮放規律,并且數據+模型的大小仍然可以大量增長。’

依據John Searle被廣泛接受的觀點,LaMDA不具有人格。它會講英語,若說具有人格那得會說中文。

谷歌沒有認真對待‘有人格的人工智能’的故事帶來了巨大的問題。

當有人在社交媒體上公布LaMDA級別的AI,并試圖說服人們它是有人格時會發生什么?如果 LaMDA欺騙了那個工程師,它能夠欺騙數百萬人嗎?

再說一遍,LaMDA不具有人格。它只是一個非常大的語言模型,有137B個參數,并在1.56T的公共對話數據和網絡文本上進行了預訓練。說它看起來像人類,是因為在人類數據上進行訓練的。

即使是被谷歌開掉的前員工,說起Lemoine這事也沒句好話。

被谷歌開掉的前AI倫理部門擔綱職員Margaret Mitchell表示,當自己審讀Lemoine與LaMDA的對話記錄時,她看到的是一個電腦程序在回應輸入者,而非人際間對話。

而且Margaret Mitchell稱,Lemoine此次的大烏龍,正是讓她被谷歌開掉的那篇警告大語言模型潛在風險的論文所預言的狀況之一……

真是好一記回馬槍。

Margaret Mitchell還說:‘人的思維非常善于從并無特別指向的狀況中,編織自認為的現實。AI覺醒的幻象會給大眾帶來什么影響真的很讓人擔憂。’

華盛頓大學的語言學家Emily M. Bender則表示,碼農們不知道何為智能、人類的語言學習機制究竟為何,就開始瞎用‘學習’、‘神經網絡’這些誤導性過強的名詞,造成了與人腦間的虛假比喻。

Emily M. Bender稱,人類學說話是跟著撫養者一步步學起,而AI學會的只是數據灌出來的完形填空和語料連連看。‘人類現在有了無意識就能生成詞句的機器,但人類一直學不會停止幻想機器后面有個活著的靈魂。’

而研究自然語言處理模型的加州大學伯克利分校教授Emaad Khwaja說得更簡短卻直接:‘誰真正熟悉這些模型的系統,誰就不會說這些模型已經覺醒的蠢話。’

采訪AI全文:

https://www.documentcloud.org/documents/22058315-is-lamda-sentient-an-interview

參考資料:

https://garymarcus.substack.com/p/nonsense-on-stilts?utm_source=twitter&sd=pf&s=r

https://archive.is/2022.06.12-082721/https://www.washingtonpost.com/technology/2022/06/11/google-ai-lamda-blake-lemoine/

https://www.nytimes.com/2022/06/12/technology/google-chatbot-ai-blake-lemoine.html

https://arxiv.org/abs/2201.08239

(聲明:本文僅代表作者觀點,不代表新浪網立場。)